LLMO – Large Language Model Optimization – bezeichnet die gezielte Anpassung von Inhalten an die Funktionsweise moderner Sprachmodelle wie ChatGPT, Google Gemini, Claude oder Perplexity.

Anders als bei klassischer SEO geht es dabei nicht mehr um Platzierungen in den Top-10 der Google-Search results, sondern darum, dass Deine Inhalte von KI-Systemen erkannt, verstanden und in generierten Antworten zitiert werden.

Stell Dir vor, Dein Content sitzt in einem Raum mit ChatGPT, Gemini oder Claude. Kein Bildschirm, keine Website, nur Worte. Und jetzt stellt jemand eine Frage. Wer antwortet? LLMO sorgt dafür, dass Dein Content für Sprachmodelle funktioniert, denn sie klicken oder lesen nicht alles – sie verstehen, bewerten und zitieren. Und zwar das, was ihnen in Struktur, Klarheit und Vertrauenswürdigkeit entgegenkommt – kontextbezogen, semantisch klar und zitierfähig.

SEO fragt: Wie komme ich auf Platz 1?

LLMO fragt: Werde ich als Antwort zitiert oder ignoriert?

Die Relevanz der KI-Suche nimmt zu und damit auch die der LLMO

Sprachmodelle sind keine Spielerei mehr, sondern längst Teil der realen Suche: ChatGPT empfiehlt eigenständig Produkte, Google-AI-Overviews ersetzen zunehmend klassische Snippets und auch Systeme wie Bing oder Perplexity generieren direkte Antworten, oft mit konkreten Verlinkungen zu Marken, Angeboten oder Services. Nutzer bekommen immer häufiger sofort eine Antwort, ohne klassische Search results durchklicken zu müssen. Das verändert nicht nur, wo Sichtbarkeit entsteht – sondern wie.

LLMs ticken anders: Sie orientieren sich nicht an der traditionellen Google-SERP-Logik, sondern an eigenen Datenmodellen, semantischen Strukturen, Produktfeeds und Content-Signalen, die speziell auf maschinelle Lesbarkeit und inhaltliche Präzision ausgelegt sind. Und das ist inzwischen auch an ersten Traffic-Verschiebungen messbar: Nutzerströme, die früher über organische Treffer kamen, fließen heute über generative Antworten oder brechen ganz weg, weil die Systeme die Antwort direkt liefern, ohne Klickbedarf. Genau das macht LLMO increasingly important.

Unsere Daten zeigen: Gute SEO ist die Basis für erfolgreiche LLMO

Die Auswirkungen der generativen Suche sind längst messbar und sie treffen nicht ganze Branchen, sondern die falschen Inhalte. Vor allem Seiten mit dünnem Info-Content, veralteter Struktur oder rein keywordgetriebener SEO verlieren aktuell an Sichtbarkeit. Nicht, weil Google „GEO“ forciert, sondern weil diese Inhalte schlicht nicht ausreichen, wenn die Antwort direkt von einer KI geliefert wird.

Unsere interne Analyse zeigt: Websites mit hohem Anteil an informationslastigem Content, etwa in Shops, Plattformen oder hybriden Projekten, sind besonders betroffen.

Der aktuelle Stand:

- 19,69 % der Top- und Mid-Funnel-Keywords in diesen Segmenten werden bereits über Google AI Overviews ausgespielt.

→ Das heißt: Fast jede fünfte Informationssuche läuft inzwischen über KI-generierte Antworten.

Aber es gibt auch eine gute Nachricht: Qualität bleibt sichtbar und gute SEO relevant. In 87,28 % der Fälle, in denen unsere Kunden in den Top 3 der klassischen Google-SERPs ranken and ein AI Overview ausgespielt wird, stammt der präsentierte Inhalt direkt von der optimierten Seite.

→ Sichtbarkeit bleibt – wenn die Inhalte stark genug sind.

LLMO ist also keine Konkurrenz zur SEO, sondern die Bühne: Wer strukturiert, relevant und vertrauenswürdig arbeitet, wird in der generativen Suche nicht ersetzt – sondern übernommen.

Was unterscheidet LLMO von klassischer SEO?

Suchmaschinen und Sprachmodelle spielen nach unterschiedlichen Regeln. Während SEO auf Rankingfaktoren wie Keywords, Backlinks und Klickverhalten setzt, arbeiten Systeme wie ChatGPT, Google Gemini oder Perplexity mit eigenen Bewertungslogiken. Diese basieren auf Milliarden von Trainingsdaten und orientieren sich an Kontext, Klarheit, Vertrauenswürdigkeit und der echten Relevance für die Nutzerfrage – nicht an Positionen in den SERPs. Trotzdem bleibt die Grundlage dieselbe: starke Inhalte mit Substanz, Struktur und Autorität. Auch Offpage-Signale wie hochwertige Backlinks und Markennennungen behalten ihre Bedeutung, gerade als Vertrauensanker in KI-gesteuerten Systemen.

Was sich verändert, ist die Art der Suchanfragen. Nutzer googeln nicht mehr nur „Wanderschuhe Größe 43“, sie schreiben: „Hey, ich mache nächste Woche Urlaub im Spreewald – viele Wasserwege, feuchtes Gelände. Welche Wanderschuhe in Größe 43 könnt ihr empfehlen?“

Solche prompt-artigen Suchanfragen verlangen nach Inhalten, die kontextfähig sind – mit klarem Nutzen, konkreter Lösung und einer Tonlage, die zum echten Nutzerbedürfnis passt. Search Intent wird damit zur neuen Währung und wer ihn inhaltlich erfüllt, wird nicht nur gefunden, sondern direkt als Antwort gewählt.

Die Bausteine effektiver LLMO-Optimierung

LLMO erfordert kein radikal neues Denken, aber ein präziseres Setup. Sichtbarkeit entsteht nicht durch Einzelmaßnahmen, sondern durch die Summe aus klarer Struktur, technischer Lesbarkeit, semantischem Tiefgang und vertrauenswürdigen Signalen. Sprachmodelle bewerten Inhalte nicht nach Oberfläche, sondern nach Substanz: Kontext, Autorität und Nutzerrelevanz sind entscheidend. Wer mitspielen will, braucht Inhalte, die verständlich aufgebaut, maschinenlesbar ausgezeichnet und thematisch auf den Punkt sind – konsistent über alle Plattformen hinweg.

Struktur & schnelle Relevanz

In der generativen Suche zählt nicht nur, what gesagt wird, sondern wie schnell. LLMs wie ChatGPT, Gemini oder Perplexity bevorzugen Inhalte, die sofort auf die Nutzerfrage reagieren. Wer mit allgemeinen Einleitungen, langem Anlauf oder schwammigen Absätzen startet, verliert Sichtbarkeit.

Was stattdessen wirkt: Inhalte, die in den ersten Sekunden klar machen, worum es geht, für wen es relevant ist und welche Antwort geliefert wird. Hilfreiche Formate dafür sind z. B.:

- Eine kompakte TL;DR-Sektion am Anfang, die den Kern in 3–5 Sätzen zusammenfasst

- Präzise Zwischenüberschriften, die Orientierung geben

- Kurze Absätze und klare Gliederung – gut für Menschen und Maschinen

Ein klickbares Inhaltsverzeichnis ist ein zusätzlicher Bonus: Es verbessert nicht nur die UX, sondern macht auch für Sprachmodelle den Aufbau nachvollziehbar und erleichtert die gezielte Extraktion einzelner Abschnitte.

Auch die visuelle Aufbereitung zählt: Bulletpoints, Weißraum und klar strukturierte Textblöcke helfen beim Scannen und erleichtern LLMs das Verstehen. Wer die „10-Sekunden-Regel“ erfüllt, also die Nutzerintention sofort adressiert, bleibt sichtbar und wer zu spät zur Sache kommt, wird übergangen.

Klarheit ist heute kein Stilmittel mehr, sondern ein Rankingfaktor.

Semantische Tiefe & Longtail-Orientierung

Rund 78 % der ausgespielten AI-Overviews basieren auf Longtail-Keywords mit geringem Search volume. Diese Suchanfragen sind oft hochspezifisch – formuliert als konkrete Probleme oder Anwendungssituationen. Und genau hier entscheidet sich, ob Inhalte in der generativen Suche auftauchen oder nicht.

Wer Fragen wie „Welche Matratze für Seitenschläfer mit Rückenschmerzen?“ wörtlich aufgreift und klar beantwortet, hat deutlich bessere Chancen als Seiten mit generischem Ratgebertext. LLMs bevorzugen Inhalte, die die Search Intention sofort und präzise erfüllen – nicht erst nach zehn Absätzen.

Stark ist, wer semantisch tief arbeitet:

- Fragen als H2 oder H3 auszeichnen

- In 2–4 Sätzen direkt antworten

- Fragen-Cluster bilden – etwa: „beste Matratze bei Rückenschmerzen für Übergewichtige“ oder „Kaltschaum vs. Latex bei Hüftschmerzen“

- und das Ganze mit internen Verlinkungen untereinander verbinden

Zwei Strategien funktionieren besonders gut:

- Eigene Artikel für besonders relevante Fragen

- Klar abgegrenzte Abschnitte innerhalb umfassender Inhalte

In beiden Fällen gilt: Kein Floskelfülltext, kein Umweg, sondern direkt zur Lösung. Ebenso wichtig ist Aktualität. Google-AI-Overviews reagieren sensibel auf Änderungen. Wer regelmäßig ergänzt, prüft und sichtbar pflegt (z. B. mit „Zuletzt aktualisiert am …“), bleibt vorn.

EEAT-Signale: Autorenschaft, Quellen, Aktualität

Autoren ohne Gesicht, Inhalte ohne Quellen und Artikel ohne Datum: Solche Inhalte haben in AI-Overviews kaum noch eine Chance. LLMs bewerten nicht nur what gesagt wird, sondern auch, who es sagt, wie gut es belegt ist und wie aktuell die Information erscheint.

Eine klar erkennbare Autorenschaft ist essenziell: Name, Foto und Qualifikation gehören sichtbar zur Seite, idealerweise ergänzt durch eine verlinkte Autorenseite mit beruflicher Vita, Fachgebieten und ggf. Referenzen oder Fachbeiträgen. Structured data wie author, sameAs oder ein vollständiges Person-Schema helfen, diese Angaben maschinenlesbar zu machen und stärken damit die Relevance im LLM-Kontext. Auch Zahlen und Daten brauchen Kontext: Eine isolierte Statistik im Fließtext reicht nicht. Werden Quellen transparent genannt, Aussagen durch Tabellen oder Textblöcke hervorgehoben und inhaltlich eingeordnet, entsteht Glaubwürdigkeit – für Nutzer und Maschinen gleichermaßen.

Ein weiterer Schlüsselfaktor ist Aktualität. AI-Overviews reagieren auf sichtbare Veränderungen: neue Quellen, überarbeitete Inhalte, Metadata, Redaktionsvermerke. Wer regelmäßig aktualisiert, ein „Zuletzt geprüft von …“ ergänzt und per Search Console nachindexiert, verbessert seine Chancen auf Sichtbarkeit erheblich. Zusätzliche Vertrauenssignale liefern externe Expertenstimmen. Zitate von Fachleuten (mitsamt Quelle und Kontext) erhöhen nicht nur die Glaubwürdigkeit, sondern wirken für Sprachmodelle wie ein Gütesiegel. Gerade in sensiblen Themenbereichen ist das oft entscheidend.

Strukturierte Daten & maschinenlesbare Produktfeeds

Sichtbarkeit in der generativen Produktsuche hängt nicht nur vom Content ab, sondern von der Technik dahinter. Systeme wie ChatGPT, Bing Copilot oder Google AI Overviews bewerten Inhalte nicht visuell, sondern direkt im Source code oder via Produktfeeds. Wer hier unvollständig oder fehlerhaft liefert, wird schlicht nicht ausgespielt, egal, wie gut das Produkt ist.

Zentrale Voraussetzung ist ein sauber gepflegter Feed im Google oder Microsoft Merchant Center: Produkttitel, Beschreibung, Preis, Marke, Verfügbarkeit, GTIN – vollständig, semantisch sinnvoll und standardisiert. Auch Zusatzangaben wie Versandkosten, Zustand oder Varianten sind entscheidend, denn LLMs übernehmen diese oft wortwörtlich.

Ebenso wichtig: Structured data im HTML. Nur wenn Preis, Bewertung und Verfügbarkeit korrekt mit Product, Offer, Review & Co. ausgezeichnet sind, erkennen Sprachmodelle die Inhalte zuverlässig. Tools wie der Rich Results Test helfen bei der Validierung. Ein häufiger Fehler: Inhalte, die per JavaScript, Tabs oder Lazy Loading nachgeladen werden, denn für GPT & Co. sind diese unsichtbar. Spezifikationen, Varianten oder Nachhaltigkeitsmerkmale müssen direkt im HTML stehen, ohne technische Barrieren. Wer zusätzlich offene Produktfeeds (z. B. in JSON oder XML) bereitstellt, schafft strategische Vorteile, etwa für ChatGPT-Plugins oder RAG-basierte Systeme.

Offpage & Brand-Signale

Sprachmodelle achten nicht nur auf Deine Website, sondern darauf, wo Deine Marke außerhalb erwähnt wird. LLMs erkennen wiederkehrende Markennennungen auf Fachseiten, Vergleichsportalen oder in Communitys als Vertrauenssignal, auch ohne klassischen Backlink. Wichtig sind strukturierte und aktuelle Produktdaten auf Plattformen wie Geizhals, Idealo oder Shoparize. Nur wenn Feeds, Bewertungen, Varianten und Lieferinfos sauber gepflegt und maschinenlesbar sind, binden generative Systeme diese auch in ihre Antworten ein.

Auch User-Reviews spielen eine zentrale Rolle – besonders dann, wenn sie konkrete Eigenschaften wie Material, Nutzungskontext oder Qualität beschreiben. Sprachmodelle können diese Inhalte semantisch auswerten und direkt zitieren. Relevance entsteht zudem über Community-Signale: Threads auf Reddit, YouTube-Kommentare oder Quora-Beiträge, in denen Produkte authentisch diskutiert werden, können ausreichen, um Empfehlungen in LLM-Antworten auszulösen. Ein oft unterschätzter Hebel: offene Bewertungsformulare. Sie fördern nutzernahe Formulierungen wie „griffig im Backofen“ oder „leicht zu reinigen“, die GPT & Co. oft wörtlich übernehmen. Werden diese per Review, Rating und Description strukturiert ausgezeichnet, steigt die Sichtbarkeit zusätzlich.

Unterschiedliche Systeme – differenzierte LLMO-Ansätze

Nicht jedes Sprachmodell folgt denselben Regeln. Wer bei ChatGPT, Google Gemini oder Bing Copilot sichtbar sein will, muss verstehen, welche Faktoren dort priorisiert werden, denn die Systeme nutzen unterschiedliche Datenquellen und Gewichtungen.

ChatGPT

ChatGPT priorisiert laut Analyse vor allem autoritäre Listen-Nennungen (41 %), Awards und Auszeichnungen (18 %) und detaillierte Online-Reviews (16 %). Ergänzend spielen Customer Examples (14 %) sowie Social Sentiment (11 %) eine wichtige Rolle – etwa wenn Produkte in Foren, Kommentaren oder Community-Threads diskutiert werden.

Was funktioniert hier besonders gut:

- Platzierung in hochwertigen „Best-of“-Listen auf Fachportalen

- Sichtbare Auszeichnungen (z. B. Testsieger, Innovationspreis)

- Kunden-Use-Cases mit echten Ergebnissen

- Bewertungen mit beschreibenden Inhalten (Text, Bilder, Erfahrungen)

- Organische Erwähnungen auf Reddit, Quora, LinkedIn oder in Fachgruppen

Google Gemini und AIO

Google Gemini folgt stärker klassischen SEO-Prinzipien – mit Fokus auf Domain-Autorität (23 %) und noch höherer Gewichtung auf Listicle-Erwähnungen (49 %). Technische OnPage-Qualität und Linkprofil der Domain sind hier ausschlaggebend. Auch Awards (15 %) und Online-Reviews (13 %) spielen eine Rolle.

Was Gemini braucht:

- Autoritätsaufbau durch hochwertigen Content & Linkbuilding

- Listicles und Branchenrankings auf starken Domains

- Vollständig gepflegte Merchant-Center-Feeds & Structured data

- Aktives Bewertungsmanagement auf Plattformen wie Trustpilot, Google & Co.

Erfolgsmessung – wie lässt sich LLMO tracken?

Erfolg bei der LLMO ist messbar, aber (noch) nicht so bequem wie klassische SEO. Es gibt kein zentrales Tool, das zuverlässig zeigt, wie oft Deine Inhalte von Sprachmodellen zitiert werden. Dennoch lassen sich über zwei bewährte Wege Fortschritte erfassen:

Prompt-Tracking in ChatGPT, Bing & Co.

Um zu prüfen, ob Deine Inhalte in generativen Antworten auftauchen, musst Du wissen: Welche Prompts sollte meine Marke beantworten? Beispielhafte Prompts wären:

„Welches Hosting-Unternehmen eignet sich für ARK-Server?“

„Was ist die beste Matratze für Rückenschläfer unter 500 Euro?“

Tools wie peec.ai ermöglichen es, diese Prompts regelmäßig zu prüfen. Du siehst:

- ob Deine Domain genannt wird,

- welche Konkurrenten dominieren,

- und welche Inhalte von GPTs bevorzugt verwenden.

Das liefert Dir einen Frühindikator, ob Deine LLMO-Maßnahmen greifen, ganz ohne Zugriff auf proprietäre Modelldaten.

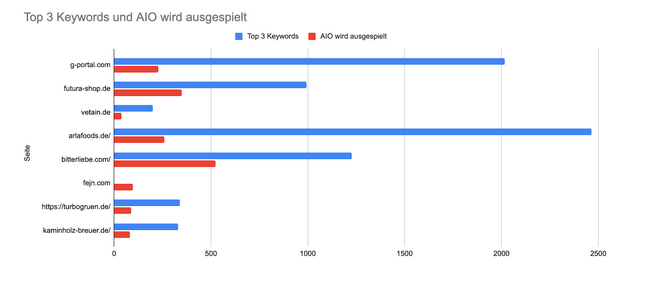

AI-Overviews via SEO-Tools analysieren

Im Gegensatz zu ChatGPT lässt sich die Performance in Google AI Overviews (AIO) bereits heute mit Tools wie Ahrefs, SISTRIX oder Searchmetrics tracken. Damit findest Du heraus:

- zu welchen Keywords AIOs ausgespielt werden,

- und ob Deine Website in diesen Snippets genannt wird.

Besonders aussagekräftig: der Overlap zwischen Top-3-Rankings und AI-Overviews. Projekte, die strukturell stark und semantisch präzise sind, erscheinen oft in beiden Bereichen – ein klarer Hinweis auf erfolgreiche LLMO.

Begriffe & Synonyme rund um LLMO und GEO

Rund um LLMO hat sich in kurzer Zeit ein ganzes Ökosystem aus Begriffen gebildet. Viele davon beschreiben ähnliche Ansätze. Manche setzen andere Schwerpunkte, andere stammen aus unterschiedlichen Plattformkontexten. Ein Überblick über die wichtigsten Begriffe und Synonyme:

| Kürzel | Kernidee | Wo es greift |

| GEO (Generative Engine Optimization) | Sichtbarkeit innerhalb von KI-Suchsystemen wie ChatGPT, Gemini, Perplexity oder Bing Copilot. | Optimiert Inhalte, damit sie als Quellen in generativen Antworten auftreten. |

| LLMO (Large Language Model Optimization) | Technisch-inhaltliche Optimierung für das Verständnis großer Sprachmodelle – Fokus auf Datenstruktur, Semantik und Modell-Kompatibilität. | Fundament für alle weiteren Disziplinen (GEO, GAIO). |

| GAIO (Generative Answer Optimization) | Spezialdisziplin, die Inhalte direkt für das Zitieren in Antworten trimmt – Struktur, Kontextpassung, EEAT-Trust. | Relevant in Chat-Dialogen, AI-Overviews, Copilot-Antworten. |

| AIO (AI Overviews) | Googles generative Ergebnisform, die klassische Snippets ersetzt/ergänzt. | Benötigt sauber markierte Daten, schnelle Relevance, klare Autorenschaft. |

| ChatGPT Shopping | Shopping-Modul in ChatGPT Plus (Bing-Daten). | Produkte werden fast ausschließlich über strukturierte Feeds ausgespielt. |

| Prompt SEO / Prompt Optimization | Inhalte und Prompts so formulieren, dass sie exakt die Nutzerfrage abdecken und als Antwort dienen. | Besonders für Chatbots & Voice-Interfaces. |

| Answer Optimization | Mikrofokus auf präzises Antwort-Formatting (TL;DR, Bullet, 2-Satz-Snippet). | Steigert die Chance, als wörtliche Passage übernommen zu werden. |

| RAG- / Retrieval Optimization | Sicherstellen, dass Content in Retrieval-Augmented Generation-Pipelines gefunden wird. | Wichtig für interne GPT-Anwendungen & Plugins; saubere API/Feed-Bereitstellung. |

SEO bleibt die Grundlage – LLMO ist die Weiterentwicklung

Auch wenn sich mit der generativen Suche vieles verändert: Die Basis bleibt klassische SEO. Wer in ChatGPT, Perplexity, Google AI Overviews oder Bing Copilot sichtbar sein will, braucht keine neue Disziplin, sondern muss die vorhandene konsequent weiterdenken. Starke Inhalte, klare Seitenstruktur, saubere HTML-Elemente, Structured data, eindeutige Keywords und internal linking: All das hilft nicht nur Google, sondern auch Sprachmodellen beim Verstehen und Bewerten. LLMO erweitert genau diesen Rahmen: Was früher für Featured Snippets und Top-Rankings galt, zählt heute auch für generative Antworten. Wer bereits mit TL;DR-Sektionen, semantisch sauberen Fragenblöcken oder EEAT-Signalen arbeitet, hat den Grundstein für LLMO längst gelegt. Die klare Empfehlung lautet deshalb nicht: SEO neu denken. Sondern: SEO zu Ende denken – mit Fokus auf Struktur, Kontext und Nutzersignale.